Vous entendez parler de la méthode RAG à tout bout de champ sans jamais tomber sur un vrai mode d’emploi ? C’est normal : la Retrieval-Augmented Generation (RAG) fait l’effet d’une petite révolution silencieuse dans l’univers de l’IA générative. On en vante la précision, la souplesse, la réduction d’hallucinations.

Mais comment ça marche, concrètement ? Par où commencer ? Et surtout : comment déployer une approche RAG vraiment solide dans votre entreprise, sans vous perdre dans la complexité technique ? Chez Mirax, on a décortiqué pour vous la méthode avec un seul objectif : vous donner toutes les bonnes pratiques pour booster la fiabilité de vos IA… sur le terrain !

RAG : pourquoi en parle-t-on partout en 2025 ?

Le modèle RAG a bousculé la donne : terminé, le chatbot qui “invente” des réponses sur la foi d’un historique dépassé. Ici, votre IA va chercher dans des sources fiables, internes ou externes, pour enrichir sa réflexion avant de générer LA réponse. Santé, banque, assurance, secteur juridique : RAG devient incontournable dès qu’il faut garantir précision, traçabilité — et rassurer les métiers, voire les régulateurs.

Les chiffres sont éloquents : en 2025, plus de 70 % des grandes entreprises du secteur financier et médical préfèrent une IA généra RAG pour assurer conformité et explicabilité (source : Squirro, The State of RAG in 2025).

L’ajout du composant RAG augmente la précision des réponses jusqu’à +35 points en conditions réelles, tout en faisant baisser drastiquement les hallucinations des modèles traditionnels (AI Multiple, 2025).

- Jusqu’à 60 % de réduction des erreurs factuelles : un boost massif sur la confiance métier.

- Coûts de maintenance abaissés de 40 à 65 % : moins besoin de réentraîner l’IA dès qu’un changement survient.

- Scalabilité exemplaire : traiter plusieurs millions de documents, sans fuite de pertinence.

Le cœur de la méthode : entre récupération, augmentation et génération

Pas besoin d’être ingénieur IA pour comprendre la logique :

- Votre utilisateur pose une question (ex : “Quel impact du nouveau Règlement IA européen ?”).

- L’IA va puiser dans vos propres documents (PDF, fiches pratiques, FAQ, notes de service…)

- Elle sélectionne les passages les plus pertinents (récupération dite ‘retrieval’).

- Elle fusionne l’info trouvée à sa propre “compréhension” du sujet, grâce au modèle génératif (augmentation + génération).

À la clé : une réponse synthétique, contextualisée, facile à vérifier — avec citation et source à la demande. Parfait pour l’audit, le conseil juridique, le support-client haut de gamme, ou piloter vos données métiers.

Déployer la méthode RAG : les vraies bonnes pratiques terrain

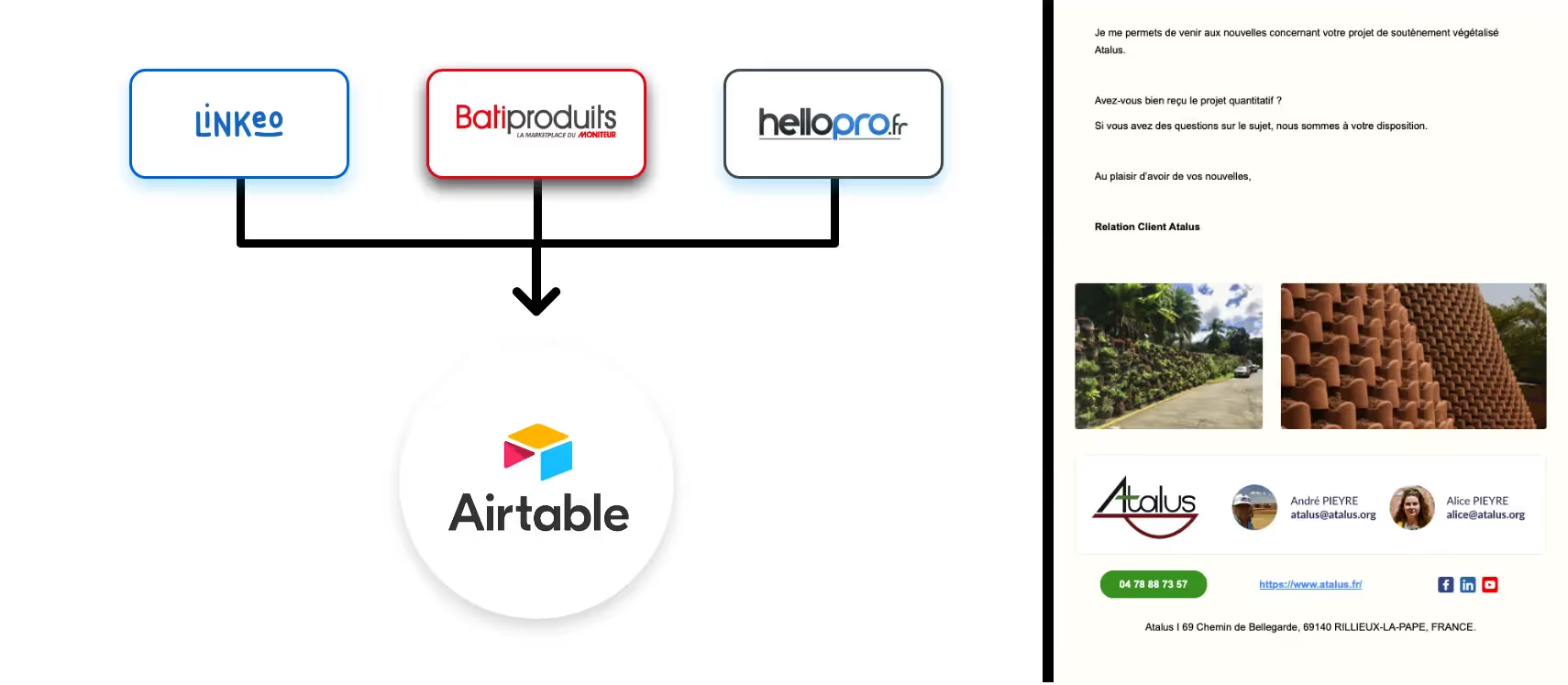

1. Commencez par… vos données ! (Et pas par l’IA)

Beaucoup se plantent : ils veulent à tout prix l’IA la plus avancée. Mauvaise idée. La priorité, ce sont vos données. Avant même d’intégrer un composant RAG, passez vos bases de connaissances au peigne fin :

- Documentez, qualifiez, nettoyez. Exit les vieux fichiers, doublons, versions contradictoires.

- Privilégiez les formats structurés : PDF indexés, bases de connaissances centralisées, ressources documentaires régulièrement mises à jour.

- Investissez dans la gouvernance : c’est elle qui rendra votre IA pertinente demain !

Chez Société Générale, le déploiement du bot « LACI » est passé par une refonte complète de la base documentaire : fusion des versions, suppression des doublons, structuration sémantique. Un passage obligé pour espérer un RAG stable et durable.

2. Tranchez le bon “chunk” : où commence la pertinence ?

Techniquement, une bonne partie de la magie RAG repose sur le découpage (le fameux chunking). Trop gros, l’IA rate la spécificité ; trop petits, elle perd le fil. En 2025, les benchmarks convergent : visez des chunks entre 256 et 512 tokens pour la meilleure balance entre précision et rapidité, surtout si vous couvrez plusieurs domaines (AI Multiple, 2025).

L’importance d’un embedding adapté

Stop au “copier-coller” d’embeddings génériques. Investissez dans des modèles adaptés à votre domaine (finances, RH, juridique…). Résultat constaté : jusqu’à +50 % d’accroissement de la précision contextuelle (Chitika, 2025).

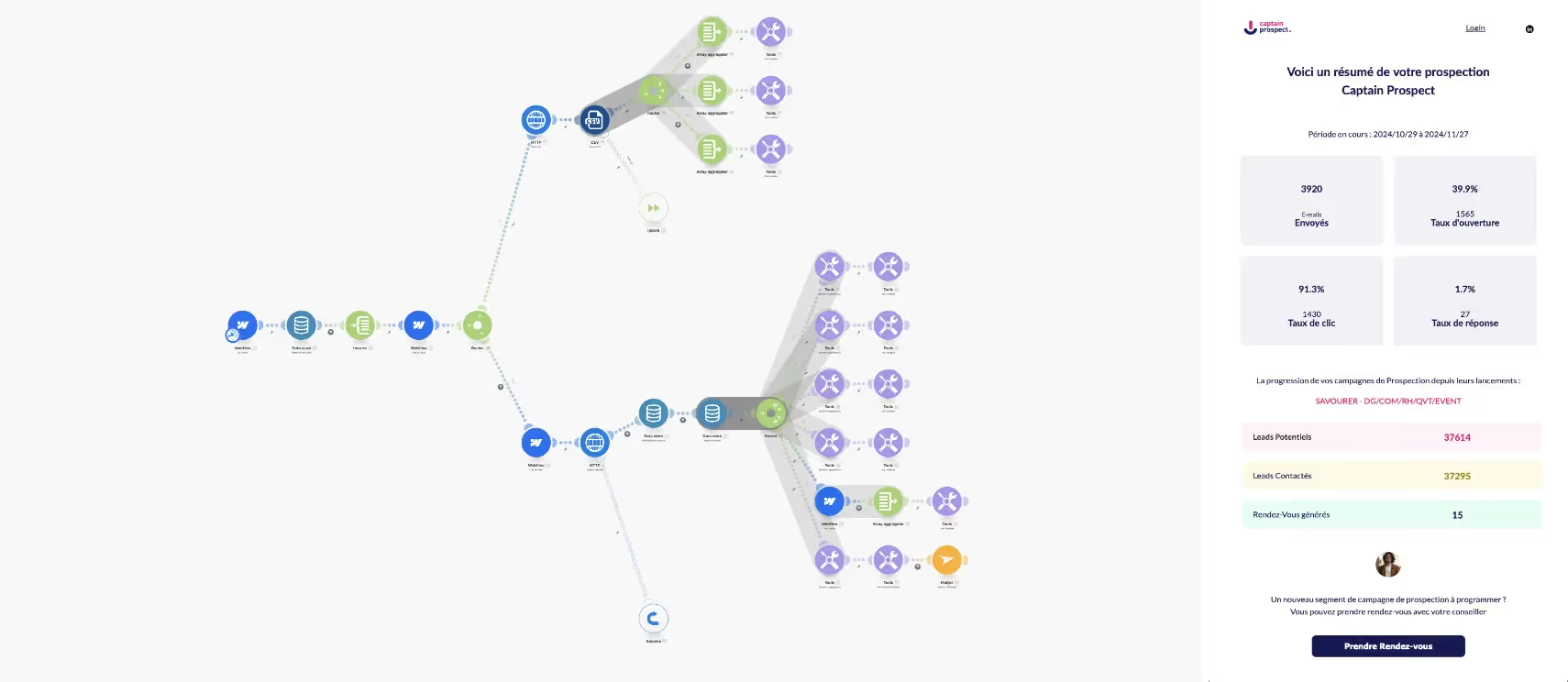

3. RAG, ce n’est pas “plug-and-play” : industrialisez votre pipeline

Tout miser sur un patchwork d’outils “à la volée”, c’est la meilleure façon de cumuler dette technique et frustration métier. Les experts terrain recommandent :

- Définir les prérequis métiers dès le cadrage (attentes, risques, contraintes légales…)

- Déployer incrémentalement, par lots de fonctionnalités, en co-construction avec les équipes

- Mesurer les performances sur des cas réels grâce à des datasets annotés typés métier (ex. : questions-réponses sur des cas d’usage), et pas juste des tests techniques

Chez Crédit Agricole, chaque mise en production passe par une batterie de tests croisés (qualité, hallucination, fidélité au corpus), validés avec les experts du métier et pas seulement l’équipe data.

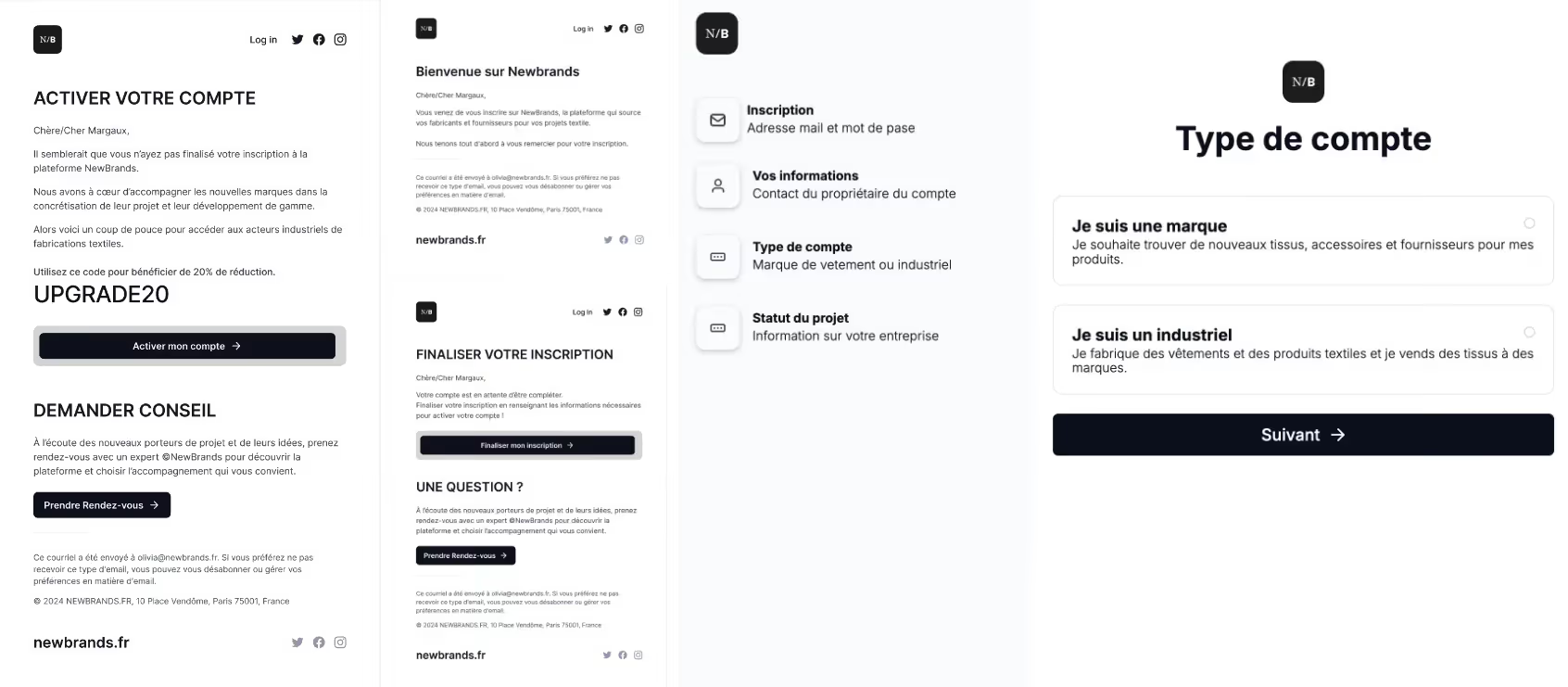

4. Boucle de feedback continue : c’est l’utilisateur qui affine l’IA !

Bonne nouvelle : avec RAG, la pertinence ne se limite pas à la première mise en route ! Les retours des utilisateurs — directement dans l’interface, à chaud — alimentent une boucle d’amélioration continue. On collecte, on ajuste, on fine-tune, on ré-embedd… De quoi maintenir le niveau d’exigence, même si votre corpus évolue chaque semaine.

5. Sécurité et conformité en entreprise : 100 % non-négociable

Santé, finance, legal… on ne plaisante pas avec la confidentialité. RAG fait gagner en contrôle par rapport au fine-tuning classique : la donnée ne quitte pas vos murs, on ne touche pas au modèle de base. Mais attention : la gouvernance de la base, le chiffrement des bases vectorielles, l’accès API sécurisé sont indispensables. Soyez pragmatiques : préférez un POC, testez la charge, analysez les limites de quota si vous partez sur des clouds publics (voir : AWS - What is RAG?).

Envie d’aller plus loin ?

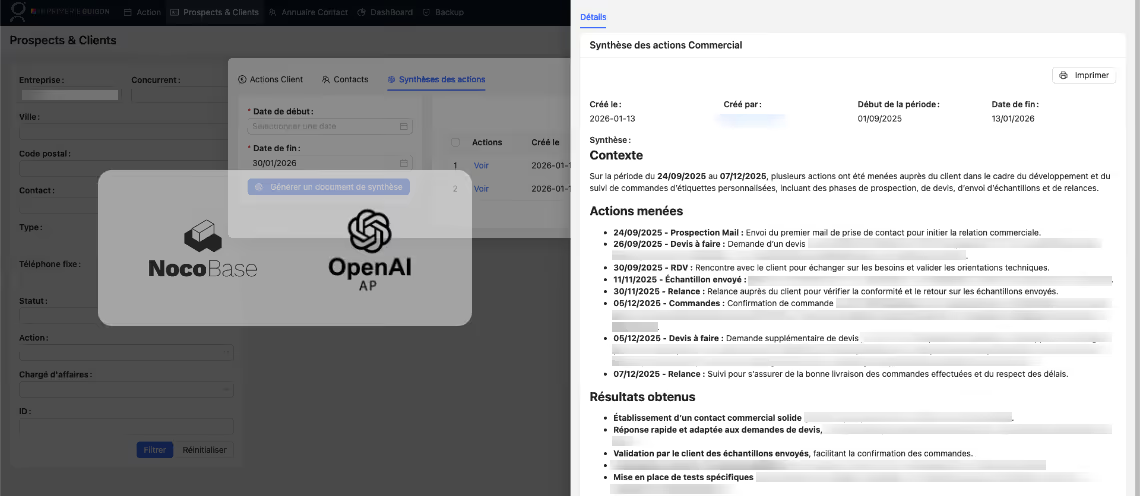

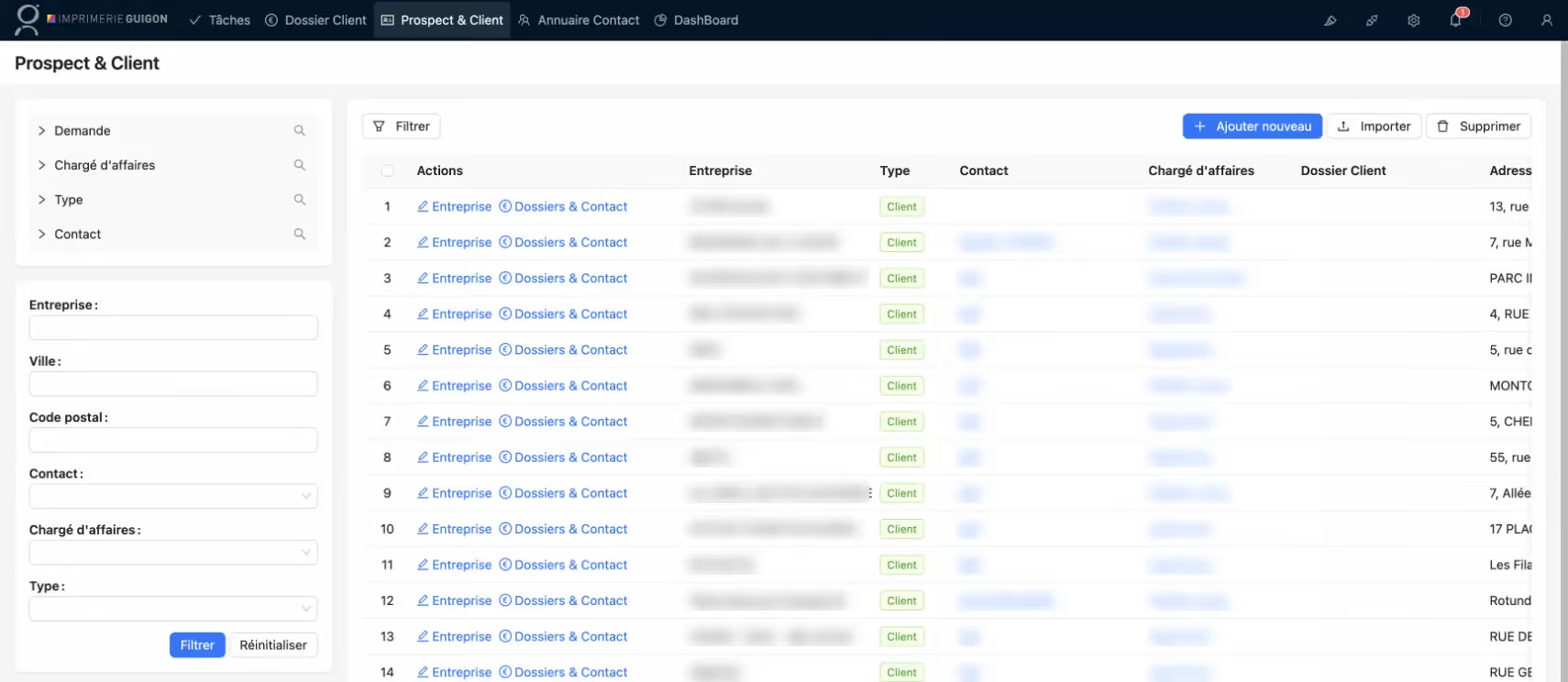

Vous souhaitez déployer une IA RAG sécurisée, intégrée à vos outils métiers, connectée à vos bases de données internes ou en lien avec vos CRM ? Découvrez notre expertise en intégration API — pour un workflow métier qui rend votre IA vraiment utile : https://www.mirax.fr/nos-expertises/integration-api

Comparatif : RAG vs fine-tuning ou modèle propriétaire ?

Pourquoi ne pas retrainer ou fine-tuner un LLM de base, plutôt que d’ajouter une surcouche RAG ? Bonne question — mais le calcul penche vite en faveur de la flexibilité et du ROI.

- Fine-tuning : idéal si vous avez un volume immense de données homogènes, mais fastidieux à maintenir, coûteux à chaque update majeure.

- Modèle propriétaire : réservé à quelques géants du secteur — complexité, délais, coûts, risques techniques accrus ; aujourd’hui, la plupart des structures préfèrent éviter.

- Approche RAG : efficace, scalable, répond réellement à la diversité de vos besoins métiers, maintenable avec des équipes mixtes (data + métier).

Autrement dit : RAG permet un accès dynamique à la connaissance, tout en réduisant les coûts et les risques de dérive du modèle.

Pour explorer ces enjeux et les subtilités techniques, examinez notre article sur l’intégration de l’IA générative d’entreprise : Voir notre article sur l'intégration des modèles LLMs

En synthèse : RAG, la colonne vertébrale d’une IA performante et digne de confiance

La méthode RAG s’impose désormais comme la référence pour toute organisation exigeant une IA générative fiable, explicable et évolutive. Plus qu’un effet de mode, c’est un choix de fond : rationalisez votre gestion documentaire, structurez vos pipelines de données, branchez vos API métiers et… mettez réellement l’IA au service de vos équipes.

En suivant ces bonnes pratiques — filtrage des données, choix du bon chunk, boucle de feedback utilisateur, sécurité et performance — vous vous garantissez des réponses à la fois crédibles, à jour et alignées avec vos métiers. Plus besoin de choisir entre prouesse technologique et pragmatisme opérationnel : la nouvelle génération d’IA conversationnelle, à l’image de la méthode RAG, vous offre le meilleur des deux mondes.

Prêt à faire passer vos projets RAG de l’idée à la réalité ? Rencontrons-nous — testez, structurez, itérez. Et surtout : placez l’expertise humaine (la vôtre, la nôtre) au centre du jeu. Ensemble, on va beaucoup plus loin !

Parlons stratégie IA dès aujourd’hui !