Arrêtez les réponses génériques, les IA “hors-sol” et les chatbots qui bredouillent : l’heure est venue de spécialiser vos modèles de langage !

Impossible de passer à côté du phénomène : en 2025, toutes les entreprises ambitieuses s’arrachent le fine-tuning de LLM open source pour prendre la main vraiment sur la pertinence, la sécurité et la valeur ajoutée de leur IA métier.

Envie de transformer GPT, LLaMA, Mistral ou Phi-3 en un allié taillé exactement pour vos enjeux ? Voici le guide terrain, par Mirax, pour passer du généraliste au champion sectoriel.

Pourquoi le fine-tuning d’un LLM Open Source s’impose en 2025

Les géants ont ouvert la voie, mais la vraie révolution, c’est pour les PME, ETI et experts métier. Oubliez les fausses promesses : en IA, la personnalisation est la clé du ROI. Et ça, les chiffres le prouvent sans ambiguïté.

- 75 % des entreprises ont intégré un LLM dans leur stack IA début 2025 (et celles qui ne l’ont pas encore fait risquent d’être à la traîne). Source : Amplework

- 60 % d’entre elles privilégient désormais les modèles open source pour une transparence, une maîtrise et une sécurité supérieures.IrisAgent

- Un LLM “finement ajusté” (27B de paramètres) a surpassé Claude Sonnet 4 (propriétaire) de 60 % sur un use-case santé, pour un coût d’inférence divisé par 10 à 100 ! Together.ai

- Résultat : gains économiques titanesques, adaptation à n’importe quel secteur (santé, industrie, assistanat juridique, RH) et indépendance technique garantie.

L’ère du LLM sur-mesure : une rupture pour l’entreprise

Fini le temps où l’IA devait se contenter de “faire le job” à moitié. Grâce au fine-tuning, vous injectez ♥️ vos données, votre jargon, vos logiques métier et votre IA comprend, réagit et anticipe avec finesse, sans surcoût délirant.

Vous voulez un agent RH qui intègre vos 40 conventions internes ? Un assistant client qui maîtrise vos contraintes RGPD ? Un moteur d’analyse médicale qui parle le même langage que vos praticiens ? C’est (enfin) possible.

Choisir le bon LLM open source et sa méthode de fine-tuning

Tout part d’un choix stratégique : quel modèle, et quel “niveau de personnalisation ”?

Là aussi, l’écosystème a explosé, et ce serait dommage de sélectionner un modèle “fermé” ou trop limité.

Les modèles open source performants en 2025

- LLaMA 3 – Plébiscité pour sa polyvalence et la qualité de sa documentation

- Mistral & Mixtral – Excellents pour les tâches multilingues et les analyses complexes de documents

- Phi-3, Gemma, Falcon – Spécialisés ou adaptés selon le volume de données métier

En pratique, ces modèles sont désormais presque tous adaptables sur du matériel standard (GPU grand public), aucun dogme : on vise simplement la bonne balance entre “taille du modèle”, données à disposition et budget.

Quelles méthodes de fine-tuning pour dompter vos coûts ?

- Fine-tuning classique – On met à jour tous les paramètres du modèle. Ultra efficace, mais vite gourmand en ressources (RAM, temps de calcul).

- PEFT (Parameter-Efficient Fine-Tuning) : LoRA, QLoRA, Adapters… On ne réentraîne qu’une fraction du modèle en intégrant des “bypass”, pour réduire de 90 % la conso mémoire/calcul. Et la qualité reste au top – c’est LA tendance 2025 (philschmid.de).

- Prompt Tuning ou RAG – Alternative pour contextualiser sans réentraîner lourdement : limite pour les cas métier nécessitant une vraie spécialisation du comportement.

On fait le point : fine-tune ou RAG ?

Pour des FAQ évolutives ou de la base documentaire fraîche, la RAG (voir notre guide) est suffisante. Mais dès que le niveau de langage, la précision contextuelle ou le respect de règles critiques entrent dans la danse : le fine-tuning s’impose (et c’est ce qui fait la différence entre un assistant d’entreprise “lambda” et un vrai copilote métier).

Étapes clés : la recette Mirax pour un fine-tuning d’IA d’entreprise qui change (vraiment) la donne

Oubliez les recettes magiques et les démo “trop belles pour être vraies”. Chez Mirax, on déroule une méthode robuste et pragmatique : vous êtes accompagné à chaque étape – cadrage, data, industrialisation, sécurité, compliance.

1. Cadrage technique et métier

On commence par challenger vos attentes. Dans quel contexte le LLM doit-il intervenir ? Quelles données sont critiques ? Quels workflows doivent être automatisés ? On découpe le projet en lots pilotables – pas de saut dans le vide.

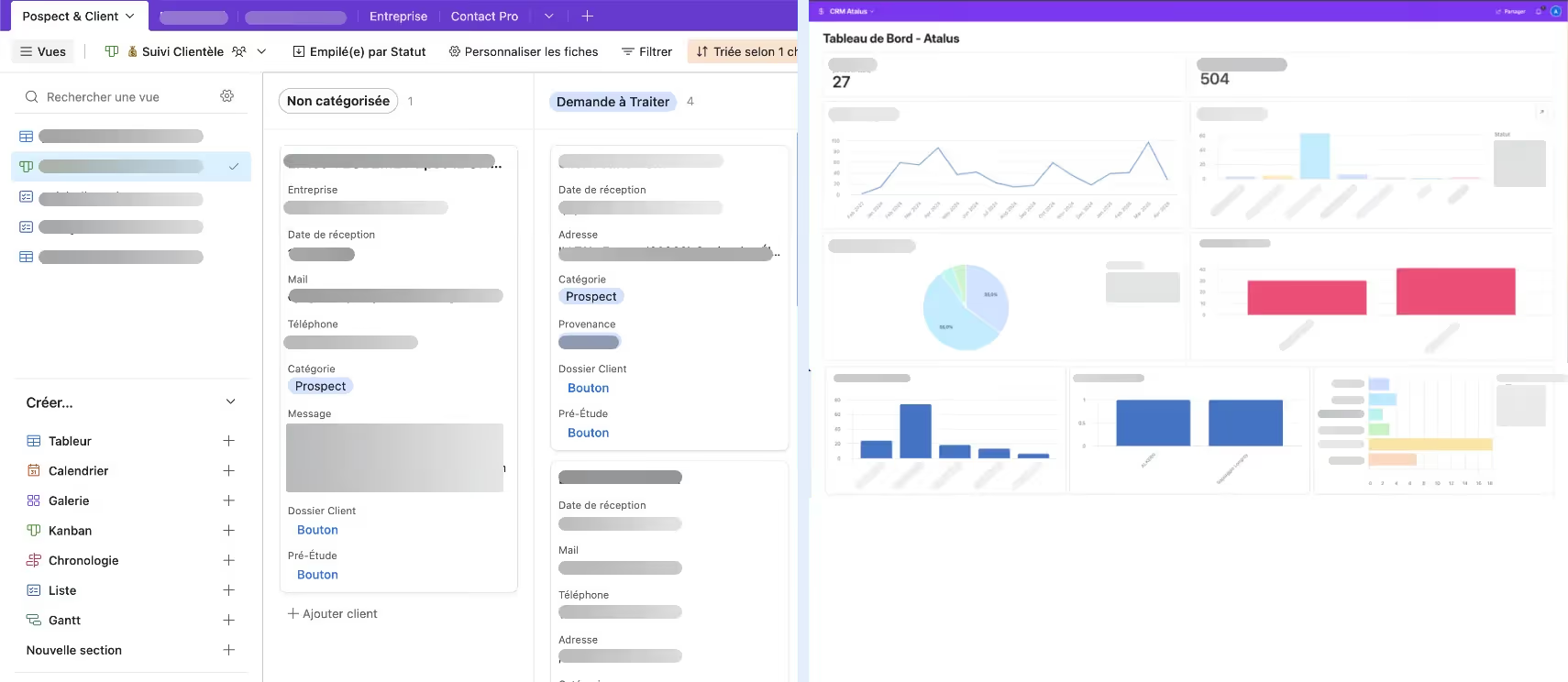

2. Constitution/curation des données

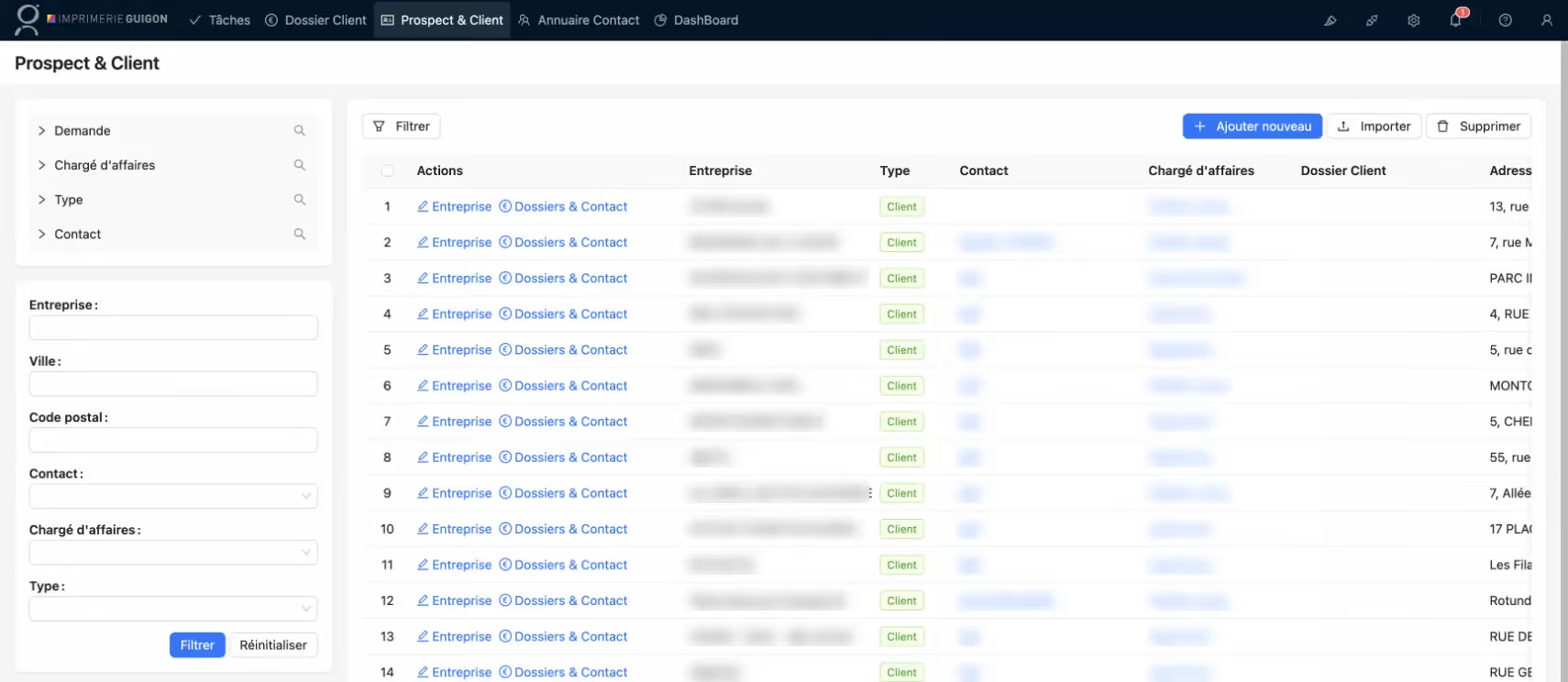

Le nerf de la guerre : vos bases de mails, tickets CRM, historiques métiers, fragments juridiques, comptes-rendus, FAQ, documents internes… On nettoie, on anonymise, on structure. On vous montre comment identifier les données à fort impact pour booster l’apprentissage sans bruit parasite.

3. Orchestration du fine-tuning

Ici, place aux méthodes modernes : LoRA, QLoRA, Adapters, peu importe l’outil, du moment qu’il colle à vos contraintes. Nos équipes s’appuient sur des frameworks éprouvés : Hugging Face, DeepSpeed, PEFT, OpenLLM… On benchmarke plusieurs variantes, on tune les hyperparamètres et… on ne sort pas de résultats sans validation terrain.

Mise en garde : la notion de licence n’est pas décorative !

Apache, MIT, CC ou “LLaMA-3 Custom” : le type de licence va conditionner l’exploitation, la revente, voire la simple utilisation commerciale du modèle. On choisit ainsi en pleine lucidité, pour ne jamais bloquer vos futurs usages.

4. Déploiement sécurisé et API à façon

Une fois le modèle finement adapté, on développe des middlewares sur-mesure pour orchestrer l’IA : connexion à votre CRM, ERP, outils métier, API dédiée, synchronisation de la data… On s’assure que la haute disponibilité, la confidentialité (données sensibles), et la conformité RGPD sont au rendez-vous.

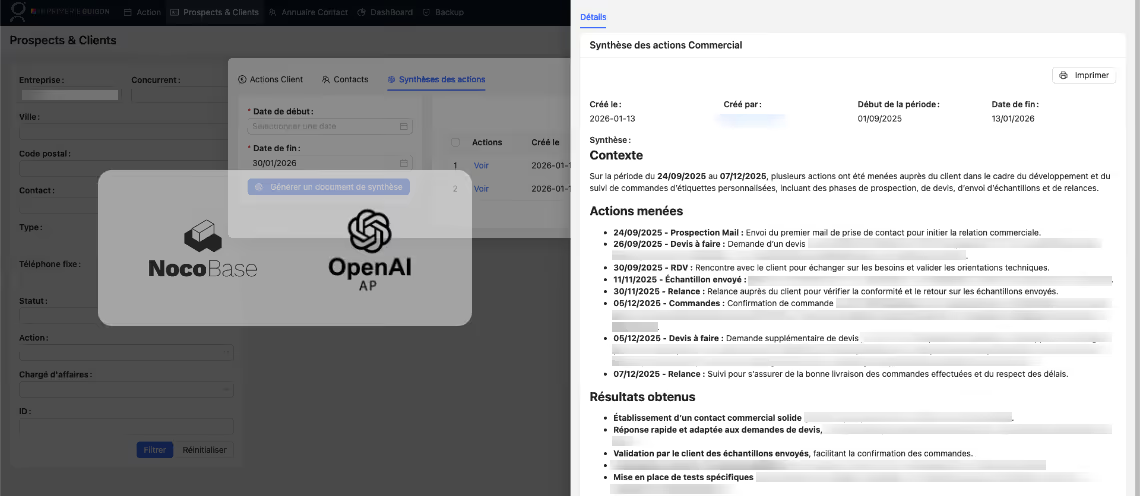

5. Monitoring, mises à jour, évolutivité

Un LLM n’est jamais “fini”. On tracke la performance en continu, on mesure l’impact (gain de temps, réduction d’erreur, taux de satisfaction utilisateur), on itère et on adapte si l’activité évolue. Notre accompagnement ? Sur le long terme, comme vos enjeux, avec des contrôles réguliers et une roadmap d’optimisation.

Fine-tuning de LLM open source : quelles économies, quels risques ?

Le passage open source/réglage sur mesure, ce n’est pas qu’un truc d’ingénieur. C’est un levier stratégique pour votre rentabilité :

- Jusqu’à 100x moins coûteux à l’exploitation qu’un modèle propriétaire sur API cloud.

- Des cas clients qui économisent plusieurs millions d’euros/an grâce à la suppression des frais d’inférence et une meilleur productivité terrain (Together.ai).

- Indépendance : on ne se bloque plus sur un géant du cloud US, la migration/portabilité sont garanties.

- Adaptation continue du modèle à vos réalités, pas à celles de l’écosystème généraliste

Mais attention :

- Le fine-tuning mal calibré peut renforcer des biais ou réduire la robustesse du modèle : c’est pour ça qu’il faut des experts !

- Le pilotage de la conformité (RGPD, normes sectorielles) doit être fait dès la curation des données et dans les pipelines de monitoring.

- La qualité des réponses, la sécurité et la “non-hallucination” ne s’improvisent pas. D’où l’importance de construire des systèmes d’évaluation métier, qui permettent de réduire jusqu’à 80 % le coût total d’itération sur vos IA (Together.ai).

Context window : la nouvelle donne des usages pro

Un détail technique qui fait toute la différence : en 2025, la fenêtre contextuelle de beaucoup de LLM atteint 1 million de tokens. Qu’est-ce que ça change ? Vous pouvez enfin générer, synthétiser ou analyser des rapports monumentaux, faire de la synthèse de documents longs, ou alimenter votre IA en contexte métier ultra-riche.

Zoom outils et frameworks : la stack Mirax pour le fine-tuning LLM

- Hugging Face Transformers & PEFT : pour orchestrer chaque étape, du prétraitement des données à la personnalisation du modèle. (Comment fine-tuner avec Hugging Face ? Demo ici philschmid.de).

- DeepSpeed : pour accélérer l’entraînement sur du matériel grand public ou multi-GPU.

- OpenLLM : déploiement sécurisé et industrialisation de vos IA custom.

- Outils Mirax : middlewares d’intégration, API, extraction automatique, monitoring intelligent. Tout est pensé pour la sécurité, la scalabilité, et la simplicité pour vos équipes. Découvrez nos expertises sur https://mirax.fr/services/agence-ia

Cas concrets et questions fréquentes

Est-ce que ma PME est “trop petite” pour se lancer ?

Non ! Le fine-tuning n’est pas réservé aux mastodontes. TPE, PME, ETI, chaque structure qui souhaite une IA alignée à ses process peut y gagner gros – en précision métier, sécurité juridique ou différenciation sectorielle. Découvrez un exemple sur notre réalisation de chatbot IA RH nos cas clients.

Combien de temps et d’effort faut-il prévoir ?

Comptez un cadrage en 1 à 2 semaines, une phase de collecte/curation de quelques jours à plusieurs semaines selon la complexité, et un fine-tuning/déploiement industrialisé en moins d’un mois sur un projet bien borné. À condition de s’entourer d’experts.

Et côté sécurité industrielle, conformité, audits ?

On déploie des workflows robustes avec traçabilité, chiffrement, logs intelligents (métier et sécurité), et on choisit des modèles avec des licences “claires” et un “audit trail” complet. On évite toute zone grise sur les droits d’exploitation.

Prêt à transformer vos données en avantage concurrentiel ?

Le fine-tuning de modèles de langage open source, c’est LA révolution métier dont votre boîte a besoin pour franchir la prochaine étape. Oubliez la “généricité” : place à une IA qui comprend, qui anticipe, qui s’adapte (et qui vous coûte jusqu’à 100 fois moins !). Chez Mirax, on vous accompagne de A à Z pour réussir ce virage technique, organisationnel et business – sans sacrifier la sécurité, la conformité ou la simplicité de gestion.

Vous avez un projet, des questions, ou simplement l’envie de tester ? Contactez-nous, et donnons vie ensemble à votre IA métier sur-mesure. L’avenir commence maintenant, et il vous appartient.